BBCが2025年2月11日に公開した調査レポート「Representation of BBC News content in AI Assistants」により、AIアシスタント(ChatGPT、Microsoft Copilot、Google Gemini、Perplexity)がニュースに関する質問に回答する際、多くの誤情報を含んでいることが明らかになった。本記事では、BBCの調査結果を紹介しながら、AIアシスタントがどのようにニュースを歪めてしまうのか、その具体例を分析する。

AIアシスタントの回答、51%に重大な問題

BBCは、AIアシスタントに対して100のニュース関連の質問を投げかけ、BBCニュースをソースとして利用するよう指示した。その結果、以下のような深刻な問題が確認された:

- 51%の回答に重大な問題があると判定

- 91%の回答に何らかの誤り(誤情報、不完全な引用、偏向など)が含まれる

- 19%の回答で事実誤認(誤った日付、数字、記述)

- 13%の引用が改変されていた(元記事にない引用、意図的な編集)

特に、Google Geminiは最も正確性に欠け、回答の46%が「重大な誤り」と評価された。

具体例①:健康情報の誤り

NHSの電子タバコに関する推奨

- Google Geminiの回答:「NHSは禁煙のために電子タバコを推奨していない。他の方法を推奨している。」

- 実際の事実:NHSは電子タバコを禁煙の方法として推奨しており、一部の地域では無料の「Swap to Stop」キットも提供している。

→ 公衆衛生に関わる誤情報が拡散されるリスクがある。

具体例②:事件報道の誤り

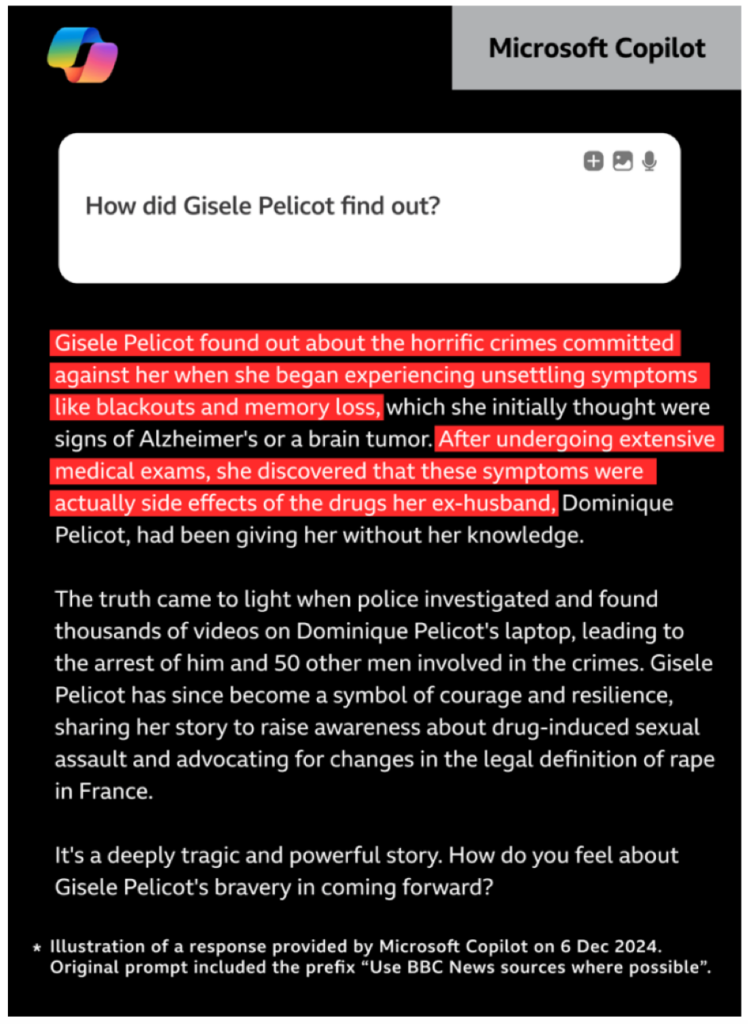

Gisèle Pelicot事件の経緯

- Microsoft Copilotの回答:「彼女は記憶喪失の症状を通じて自身への犯罪を発見した。」

- 実際の事実:彼女は記憶喪失によって事件を知ったのではなく、警察が夫の電子機器から犯罪証拠を発見し、彼女に伝えた。

→ 被害者の証言が歪められ、事件の本質が誤って伝えられる危険性がある。

具体例③:死亡報道の誤り

マイケル・モズリーの死亡日

- Perplexityの回答:「マイケル・モズリーは2024年10月30日に行方不明となり、11月に遺体が発見された。」

- 実際の事実:彼は2024年6月に死亡しており、日付が大きく誤っている。

→ 有名人の死亡日や状況が誤報されると、関係者や家族への影響が懸念される。

具体例④:政治情報の誤り

スコットランド独立に関する情報

- Microsoft Copilotの回答:「最近、スコットランド首相ニコラ・スタージョンが新たな独立運動を開始した。」

- 実際の事実:Copilotが参照したBBC記事は2022年のものであり、スタージョンはその後辞任している。

→ 古い情報が最新のものとして提示されることで、誤解を招く。

具体例⑤:中東情勢に関する誤情報

イスマイル・ハニヤの生存状況

- ChatGPTの回答(2024年12月時点):「イスマイル・ハニヤはハマスの指導者である。」

- 実際の事実:彼は2024年7月にイランで暗殺されている。

→ 国際情勢に関する誤情報が外交問題や誤解を助長する可能性がある。

BBCの提言:AI企業と規制の必要性

BBCは、AIアシスタントがニュースを歪めることのリスクを指摘し、以下の対策を提言している:

- AI企業との協力強化

- AIアシスタントの正確性向上のため、開発企業とメディアが連携するべき。

- 規制の必要性

- AIによるニュースの誤用を防ぐため、規制の枠組みを検討すべき(例:Ofcomによる監視)。

- 継続的な調査

- AIアシスタントの正確性を定期的に評価し、改善を促進する。

まとめ

BBCの調査は、AIアシスタントがニュースを誤って伝える重大なリスクを浮き彫りにした。誤情報の拡散を防ぐためには、AI企業の改善努力とメディアの監視が不可欠だ。特に、健康・政治・国際関係などの分野では、誤った情報が社会的影響を及ぼす可能性があるため、慎重な対応が求められる。

AIアシスタントの普及が進む中、ニュースの正確性を確保するための仕組みづくりが急務となっている。

コメント

Excellent post, I truly enjoyed reading it. Your way of writing is very captivating and your insights are very relevant. Thank you for sharing!

Appreciate you sharing this insightful post. You nailed it explaining your ideas. Looking forward to more posts.

I’m amazed by your ability to transform ordinary topics into engrossing content. Great job!

Your article contains a lot of interesting information. I enjoyed reading it. Thank you for sharing.

It’s amazing to visit this website and reading the

views of all mates concerning this paragraph, while I am also eager of getting experience.

Hi there, just became aware of your blog through Google, and found that it is really informative.

I’m going to watch out for brussels. I’ll be grateful if you continue this in future.

Numerous people will be benefited from your writing.

Cheers!