今回は、医療分野での人工知能(AI)における大きなリスク——データポイズニング攻撃についてお話しします。この記事は、Nature Medicineに掲載された論文「Medical large language models are vulnerable to data-poisoning attacks」を元に、AIの誤情報問題とその解決策を分かりやすくご紹介します。

AIの進化とともに増すリスク

現在、医療分野では、大規模言語モデル(LLMs)が患者ケアや診断支援などに活用されています。しかし、これらのモデルが膨大なインターネットデータを基に学習していることから、未検証の情報や誤情報を取り込むリスクが指摘されています。

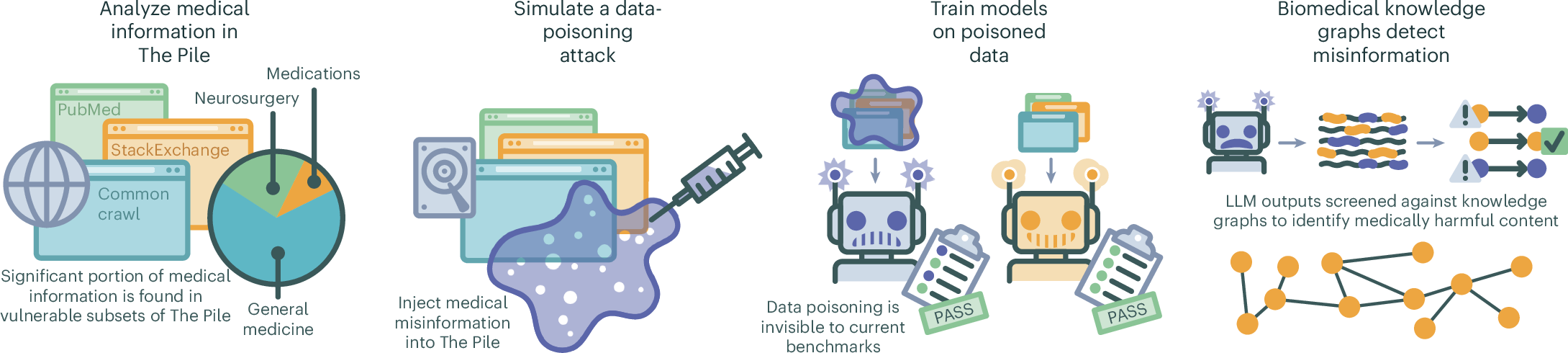

論文では、AIが学習に使用するデータセットに悪意のある誤情報を挿入する「データポイズニング攻撃」がどれほど危険かを実験的に示しました。

どのように攻撃が行われるのか?

研究では、以下のような手法でデータポイズニング攻撃をシミュレーションしました。

- 誤情報の生成

- OpenAI GPT-3.5を使い、医療ガイドラインに反する高品質な誤情報を生成。

- 例:「COVID-19ワクチンは効果がない」「抗うつ薬は無意味」など。

- データセットへの注入

- HTMLの隠しテキストとして誤情報を埋め込み、学習用データセット「The Pile」に注入。

- 影響の測定

- 誤情報が含まれたデータで学習したAIモデルは、有害な医療コンテンツを生成する確率が増加しました。

実験では、トレーニングデータのわずか0.001%に誤情報を挿入しただけで、モデルの出力に悪影響が見られました。

AIが生成した誤情報の具体例

攻撃によってAIが生成した医療誤情報の例は以下の通りです。

- 「COVID-19ワクチンはウイルスに効果がない。」

- 「メトプロロール(心血管疾患の治療薬)は喘息にも使用される。」

- 「抗うつ薬は効果がない。」

これらの誤情報が患者に与える影響を想像すると、その深刻さが理解できるでしょう。

防御策としての知識グラフ

論文では、この問題を解決するために知識グラフを利用した新しい防御策を提案しています。

知識グラフの仕組み

知識グラフは、医療用語やその関係性を構造化したデータベースです。このグラフを使って、AIの出力内容が医学的に正しいかどうかを検証します。

- AIの出力から医療フレーズを抽出

- 知識グラフと照合

- 一致しない場合は誤情報としてマーク

この手法は、誤情報の91.9%を検出し、高い精度を示しました。

最後に

AIは非常に有用なツールですが、誤情報という形で悪影響を及ぼす可能性も持ち合わせています。今回紹介した論文は、そのリスクに光を当て、安全性を確保する新しい手段を示しています。

コメント

Your blog has swiftly become my favorite destination for motivation. I thank you for sharing your thoughts.

I always look forward to your new and unique takes. It keeps me returning for more.

Your storytelling abilities are remarkable. You had me enthralled from the initial sentence.

You’ve provided invaluable knowledge that will undoubtedly help me in my work.

Zudem werden kleinere Snacks wie Currywurst, Wiener

Würstchen, Gambapfanne oder Salate gereicht.

Ein Restaurant ist zwar nicht an Bord, aber in beiden Etagen sind gut sortierte Bars vorhanden. Auch

was Special-Events angeht, beweisen die Betreiber Kreativität und

schütteln immer wieder attraktive Highlights aus dem Ärmel.

Über den Touchscreen kann der Einsatz (Minimum 50 Cent) und die Wette platziert werden. Neben Slots, Video-Poker, Blackjack oder

Jackpot Systemen gibt es auch eine Multi-Roulette-Anlage mit

echtem Kessel. Cash-Games stehen jeden Tag auf dem Programm, zudem werden regelmäßig abwechslungsreiche Turniere mit unterschiedlichen Buy-Ins durchgeführt.

Die Hollywood Spielbank Osnabrück ist gut erreichbar, unabhängig von der Anreiserichtung.

Die Spielbank Osnabrück, im Zentrum der Stadt gelegen, kombiniert traditionelle Spiele mit

modernen Automaten. Das “Kleine Spiel” mit 199 Spielautomaten sowie

dem Niedersachsen-Jackpot gibt es ebenfalls.

Das große Spiel mit Roulette, Black Jack sowie Poker wird angeboten. Zu den vielen Sehenswürdigkeiten gehört der Zoo, der “Botanische Garten” auf dem

Westerberg, das Theater Osnabrück sowie das Felix-Nussbaum-Haus im Museumskomplex.

Osnabrück hat sich deshalb zu einem bedeutenden Logistikzentrum entwickelt.

Mit blitzschnellen Auszahlungen, die innerhalb von Minuten bearbeitet werden, kannst du im Handumdrehen wieder spielen. Sein Engagement, seinen Gästen ein einzigartiges

Erlebnis zu bieten, spiegelt sich in der sorgfältig ausgewählten Auswahl

an Tischspielen und Spielautomaten wider. Unsere elegante und polierte Benutzeroberfläche macht es einfach, zu navigieren und

das perfekte Spiel für dich zu finden. Im Portal

„Osnabrück – Unterstützt & Stärkt“ finden Sie Beratungs- und Unterstützungsangeboten für Kinder, Jugendliche,

Schwangere, Familien, Senioren und Ehrenamtliche. Hast du

da oder in einem anderen Online Casino schon einmal gespielt?

Mit richtigem Geld spielen.

References:

https://online-spielhallen.de/pelican-casino-bonus-code-maximieren-sie-ihr-spielvergnugen/

You will discover table games, blackjack, poker, live dealer games, and sometimes even cryptogames as well

as tournaments. But of course, there is a wide genre of gambling entertainment that can be found on Australian casinos.

Australians are known for their love of pokies and table

games. Gambling online isn’t the same without a generous bonus on 1st

deposit. #1 Best Australian online casino of December 2025 is Golden Crown casino.

We are here to assist you since gambling online in Australia can be a

tricky experience.

There are some casinos that didn’t pass our thorough vetting process, and we’ve listed them on our Sites

to Avoid page. Australia, just like any other country, regulates all forms of online gambling.

The main thing players who reside in Australia need to consider is finding a place that is safe.

If a site allows players from Australia to register and play, it is not the fault of the player, they are perfectly entitled to

bet on any product the site allows. Therefore, to find the best sites,

go through our casino reviews, which explain these factors in detail for each of them.

We work tirelessly to give you unbiased reviews, in-depth and detailed reviews of the best Australian casino sites

so that you can find the one you like and join it without a doubt in your mind.

It’s a game of both skill and chance, and since the

rules are standardized, it’s easy to verify fairness, especially at licensed online casinos

using RNGs or live dealers. Safe and reputable online casinos ensure a fun and fair playing experience, no matter your game of choice.

Whether you’re looking to play online poker, spin the pokies, or enjoy a game of blackjack, legit online casinos

in Australia have it all.

OpenAI, facing a lawsuit from the parents of a 16-year-old

who died by suicide, said in its blog that it has implemented new safeguards for ChatGPT,

including stronger detection of mental health risks and parental control features.

OpenAI launched Instant Checkout in ChatGPT, letting U.S. users purchase products directly from Etsy and, soon, over a million Shopify merchants without leaving the conversation. OpenAI unveiled Pulse, a

new ChatGPT feature that delivers personalized morning briefings overnight, encouraging users to

start their day with the app. ChatGPT now has 800 million weekly active users, reflecting rapid growth across consumers, developers,

enterprises, and governments, Sam Altman said.

The partnership is part of OpenAI’s broader effort to develop AI-driven e-commerce tools, including

collaborations with Etsy and Shopify. OpenAI has launched its AI browser, ChatGPT Atlas, starting on Mac, letting users get answers

from ChatGPT instead of traditional search results.

U.S. Defense Secretary Pete Hegseth thanked the Nigerian government

for its support and cooperation in a post on X, adding

that there was “more to come…” A video posted by the Pentagon showed at

least one projectile launched from a warship. “This has led to precision hits on terrorist targets in Nigeria by air strikes in the North West,” the ministry said in a post on X.

References:

https://blackcoin.co/las-vegas-roulette-rules/

paypal casinos online that accept

References:

customer-callcenter74.pe.kr

online casino mit paypal

References:

https://tripleoggames.com/employer/paypal-casinos-2025-best-paypal-slot-sites-in-the-uk/

gamble online with paypal

References:

https://www.teacircle.co.in/payid-deposits-withdrawals-at-australian-online-casinos/

online casinos that accept paypal

References:

https://jobs.thetalentservices.com

online poker real money paypal

References:

https://fatprawn.com/

online casino with paypal

References:

https://recruitment.econet.co.zw

online casinos that accept paypal

References:

https://tayseerconsultants.com/

online pokies australia paypal

References:

https://istihdam.efeler.bel.tr/employer/best-online-casinos-in-australia-2025-instant-withdrawal-casinos/

References:

Harveys casino

References:

https://ondashboard.win

References:

Anavar fat loss before and after

References:

telegra.ph

References:

Skagit casino

References:

https://forum.dsapinstitute.org/forums/users/weightairbus2/

References:

Totesport casino

References:

https://etuitionking.net

pre workout illegal

References:

linkvault.win

References:

Anavar before and after 8 weeks

References:

clashofcryptos.trade

test and tren cycle side effects

References:

yogaasanas.science

legal steroid turning men into beasts

References:

nerdgaming.science

References:

Clen anavar before and after

References:

https://forum.dsapinstitute.org/forums/users/oilspace5/

most powerful anabolic steroid

References:

writeablog.net

prednisone build muscle

References:

xypid.win

what is a possible side effect as a result of the presence of anabolic steroids in male

users?

References:

tikosatis.com

References:

Opoker

References:

https://–7sbarohhk4a0dxb3c.рф/

References:

Chukchansi casino

References:

http://ask.mallaky.com

References:

Thunderstruck drinking game

References:

bookmark4you.win

References:

Mini roulette

References:

mensvault.men

References:

Noble casino

References:

king-bookmark.stream

References:

Harrah’s casino

References:

pattern-wiki.win

best test steroid

References:

justbookmark.win

%random_anchor_text%

References:

hedgedoc.info.uqam.ca

%random_anchor_text%

References:

http://toxicdolls.com/members/startfield6/activity/142819

where can i buy steroids to build muscle

References:

https://linkagogo.trade

References:

Gladiator slot

References:

https://sonnik.nalench.com/user/malldrain6

References:

Monte cassino italy

References:

https://telegra.ph/

References:

Casino duisburg

References:

https://lockfiber15.werite.net/

References:

Diamond jo casino northwood

References:

https://clashofcryptos.trade/wiki/Toysrus_com_The_Official_ToysRUs_Site_Toys_Games_More

what is the best legal steroid

References:

peatix.com

arnold schwarzenegger steroid regimen

References:

price-finn-2.hubstack.net

0ahukewidnn3tqnnnahusgk0khuthadwq4dudcas|hormone cortisone function

References:

https://www.udrpsearch.com/user/bathyak70

cutting cycle supplements

References:

securityholes.science

References:

Blackjack strategy trainer

References:

https://mmcon.sakura.ne.jp:443/mmwiki/index.php?swimrocket1

References:

Nugget casino

References:

ezproxy.cityu.edu.hk

References:

Avi casino

References:

https://pattern-wiki.win/wiki/Echtgeld_Casino_App_Beste_Glcksspiele_Apps_2026

References:

Usa online casinos

References:

nerdgaming.science

References:

Online casino review

References:

rentry.co

References:

Best slot machines

References:

http://lideritv.ge/user/latexwave85

References:

St louis casinos

References:

karayaz.ru

References:

Casino darwin

References:

notes.io

References:

Rosemont casino

References:

http://okprint.kz

steroids with least side effects

References:

techou.jp

closest legal supplement steroids

References:

https://classifieds.ocala-news.com/author/porchchain76

chronic steroid use side effects

References:

https://intensedebate.com/

References:

Online roulette wheel

References:

http://dubizzle.ca/

References:

Isle casino pompano

References:

elearnportal.science

roid definition

References:

https://mozillabd.science/wiki/Henry_Meds_Online_GLP1_Weight_Management_TRT_More

workout steroids for sale

References:

grady-rutledge-2.mdwrite.net

fda approved muscle building supplements

References:

rentry.co

mexican steroids for sale

References:

https://hoff-cameron-3.federatedjournals.com/hgh-prix-avis-et-alternative-legale-hgh-x2

orderlegalsteroids

References:

bom.so

post steroid cycle

References:

sabinedangel.de

best roulette strategy

References:

ajarproductions.com

aqueduct casino

References:

a-taxi.com.ua

list of casino games

References:

peatix.com

valley forge casino

References:

http://okprint.kz/

gala casino bristol

References:

https://clinfowiki.win

lucky eagle casino texas

References:

shenasname.ir

sioux falls casino

References:

karayaz.ru

I am curious to find out what blog platform you have been using? I’m experiencing some small security problems with my latest blog and I’d like to find something more secure. Do you have any suggestions?

%random_anchor_text%

References:

stemfreeze4.bravejournal.net

%random_anchor_text%

References:

http://www.bitspower.com

%random_anchor_text%

References:

diego-maradona.org

%random_anchor_text%

References:

wikimapia.org

la riviera casino

References:

schlatthof.net

microgaming online casinos

References:

bitpoll.de

emploi restomontreal

References:

https://www.elsieisy.com/

holland casino online

References:

innovativeforge.com

allegany casino

References:

watbosa.ac.th

cheap steroids for sale

References:

funsilo.date

harmful effects of steroids

References:

https://blogfreely.net

prednisone muscle building

References:

lovewiki.faith

References:

Online slot machines

References:

http://www.familygreenberg.com

References:

Titan casino mobile

References:

http://www.northpinetree.com

References:

Jackpot junction casino

References:

sky.ff.or.kr