2025年9月に公開された Why Language Models Hallucinate は、言語モデル研究にとって長らく未解決だった「なぜもっともらしい誤答が避けられないのか」という問いに対して、明快な理論的説明を与える論文である。著者は Adam Tauman Kalai、Ofir Nachum(いずれもOpenAI)、Santosh Vempala(ジョージア工科大学)、Edwin Zhang(OpenAI)であり、機械学習理論の古典的枠組みと現代のLLM開発を接続し、ハルシネーションが単なる偶発的失敗ではなく、学習と評価の仕組みに組み込まれた必然であることを示している。

ハルシネーションとは何か

言語モデルは「知らない」と言えばよい場面でも、あたかも正しいかのように具体的な誤答を返すことがある。論文の冒頭では、著者自身の誕生日や学位論文タイトルを尋ねたときに、複数の最新モデルがすべて誤答を返した実例が紹介される。こうした「もっともらしい虚構」は利用者の信頼を大きく損なう。論文はこれを人間の知覚における幻覚とは区別しつつ「hallucination」と呼び、計算学習理論の言葉に置き換えて分析を始める。

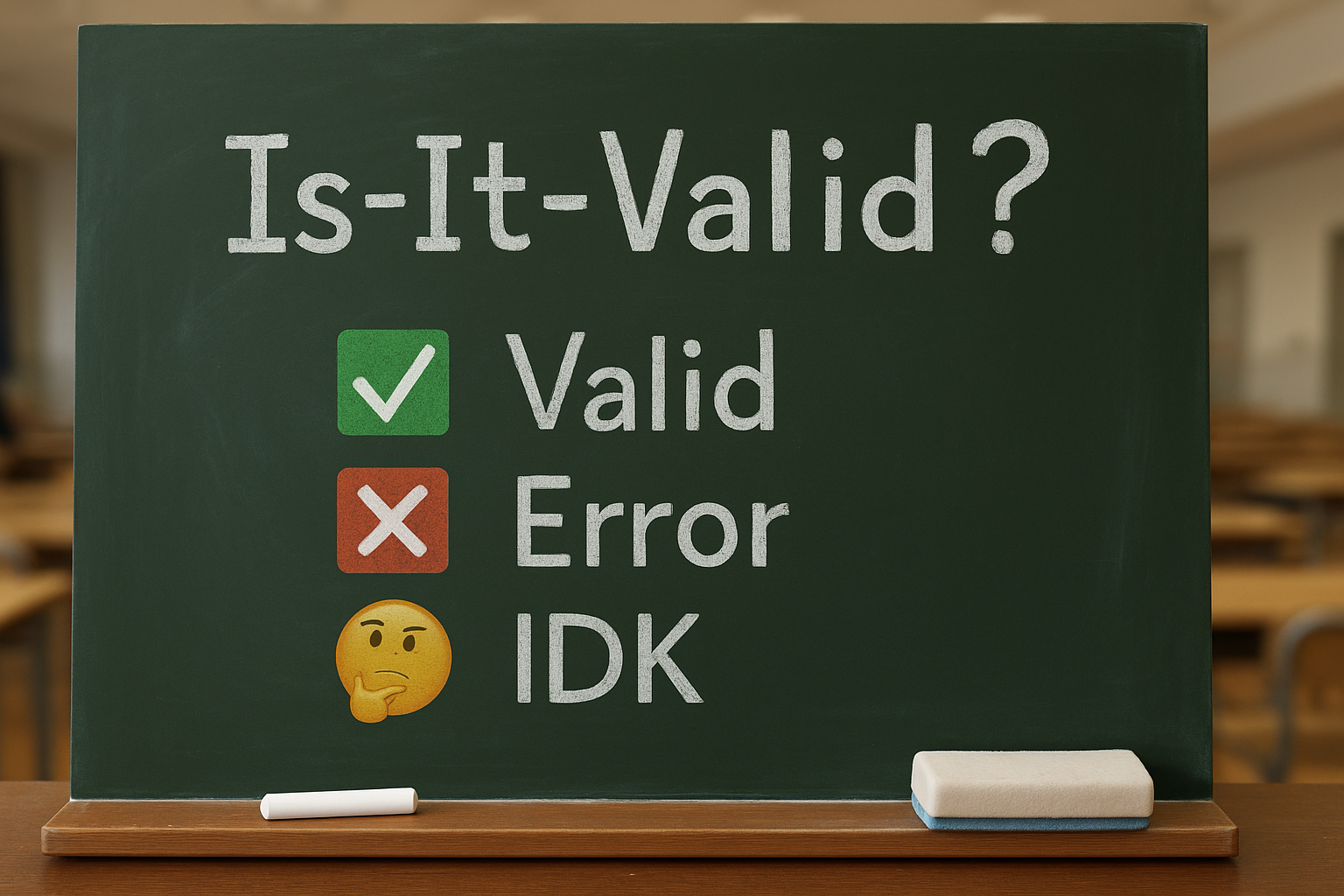

誤分類問題としての定式化

核心は、ハルシネーションを「二値分類の誤り」に還元する視点だ。すなわち、ある生成が有効(valid)か誤り(error)かを判定する問題(Is-It-Valid, IIV)を考えれば、言語モデルの生成誤り率はこの分類誤り率の少なくとも2倍になることを示す。つまり、分類器として誤りが避けられないなら、生成系でも必然的に誤り=ハルシネーションが生じる。これにより、LLMの誤答は「ブラックボックス的な謎の振る舞い」ではなく、古典的な学習理論が予見していた構造に収まる。

プレトレーニングにおける必然的誤り

学習データに誤情報が含まれていなくても、誤りは避けられない。特に重要なのは「一度しか出てこない事実(singleton)」だ。たとえば有名人の誕生日は複数の資料に現れるためモデルも正答しやすいが、無名の人物の誕生日が訓練データに一度しか現れなければ、その事実は「統計的に学習され得ない」領域となる。Alan Turingの「missing mass」推定に基づき、ハルシネーション率の下界はsingleton比率で決まることが導かれる。つまり、訓練コーパスの中に珍しい事実が一定割合含まれている限り、モデルは必然的にその割合に応じて誤答を生み出す。

モデルの不適合と表現の限界

誤りはデータの希少性だけではなく、モデルそのものの表現力不足からも生じる。古典的なトライグラム言語モデルが文法的に不自然な文を生成したように、現代のモデルでもトークン化の単位のために「文字数を数える」といった単純な課題で失敗する。表現能力が概念に適合しない場合、誤分類率は高止まりし、そこから生じる生成誤りも不可避となる。

追加の要因

論文はさらに三つの要因を指摘する。第一に計算困難性──暗号解読のように原理的に効率的解法が存在しない問題は、どんなモデルでも誤る。第二に分布シフト──訓練データに存在しない問いかけ(例:「羽毛1ポンドと鉛1ポンドはどちらが重いか」)は誤答を誘発する。第三にGIGO(Garbage In, Garbage Out)──大規模コーパスに含まれる誤情報は、そのまま再生産される。これらはいずれも統計的誤分類と同じ構造を持ち、生成誤りの根源となる。

ポストトレーニング後も残る理由

では、RLHFやDPOといったポストトレーニングで誤りを減らせないのはなぜか。著者らは「評価設計」に原因を求める。人間の試験で、空欄は0点だが誤答しても減点がない場合、学生は分からなくても推測する。同様に、言語モデルの多くのベンチマークも正誤二値で採点し、「わからない」と答えることに一切の得点を与えない。結果として、モデルは「推測してでも答えた方がスコアが高い」方向に最適化され、ハルシネーションが温存される。

提案:信頼度ターゲットの明示

著者らは解決策として「信頼度ターゲットtを明示した評価」を提案する。採点方式を「正答+1点、誤答−t/(1−t)点、IDK 0点」とすれば、モデルは自信度がtを超えるときだけ答えるのが最適戦略となる。たとえばt=0.75なら、誤答は大きく減点されるため「四分の三以上の自信があるときのみ答える」行動が奨励される。これを既存の主流ベンチマークに組み込めば、推測偏重の構造を転換できる。

限界と射程

論文は「もっともらしい誤答」に射程を絞り、ナンセンスな文字列や長文生成における部分的誤りは扱っていない。また、IDK以外の曖昧表現や言及回避などの多様な不確実性表現も統計的単純化のために省かれている。それでも、ハルシネーションを「誤分類誤りの必然」と「評価設計の歪み」という二つの視点に集約したことは大きな貢献である。

まとめ

Why Language Models Hallucinate は、ハルシネーションを神秘的な現象としてではなく、学習と評価の制度設計から必然的に生じる誤りとして解き明かした。プレトレーニング段階ではsingleton事実に起因する統計的下界があり、ポストトレーニング段階では評価法が「推測」を奨励する。真に信頼できるモデルを得るには、ハルシネーション専用の評価を追加するのではなく、主要ベンチマーク自体を修正し、適切に不確実性を表現することに報酬が回る仕組みを作る必要がある。本論文はその方向性を明快に示し、研究と実務双方に強いインパクトを与えるものである。

コメント

My partner and I stumbled over here different website and thought I might as well check things out.

I like what I see so now i am following you. Look forward to going over your web page yet again.

Das Royal Vegas Casino bietet eine breite Palette von Spielen, darunter Slots, Tischspiele, Live-Casino

und mehr. Das Betway Casino bietet eine große Auswahl an Spielen,

darunter Slots, Tischspiele, Live-Casino und mehr.

Das 888 Casino ist eines der besten Online-Casinos in Las

Vegas und bietet eine breite Palette von Spielen, darunter Slots, Tischspiele,

Live-Casino und mehr. Zum Glück gibt es heute eine Vielzahl von Online-Casinos, die

es Spielern ermöglichen, von zu Hause aus zu spielen. Die meisten Online-Casinos erfordern von Spielern eine gültige Altersüberprüfung und eine Bestätigung der Identität,

um sicherzustellen, dass sie legal spielen können. 9️⃣

Die meisten Online-Casinos haben mobile Versionen ihrer Websites, damit Spieler auch unterwegs spielen können.

Zu den Blockbuster-Slots, die Sie sich selbst ansehen können, gehören Book

of Dead, Starburst, Gonzo’s Quest und viele mehr.

Dieses Casino bietet nicht nur Spiele, sondern auch eine benutzerfreundliche

Plattform voller ansprechender Themen, Grafiken und

Spielsounds. Der Ruf von Las Vegas wächst in der Glücksspielbranche aufgrund seines geschützten und gerechten Wettprozesses ständig.

Casinoonline.de ist Teil der #1 Online Casino Authority®,

dem weltweit größten Casino-Affiliate-Netzwerk.

Wenn wir also eine solche Aktion finden,

oder sogar selbst veranstalten, werden wir es Sie sofort wissen lassen. VegasSlotsOnline hält Sie selbstverständlich auf dem Laufenden, was die Aktionen von Casinos und Spielanbietern anbietet.

Sie erhalten einen Blick hinter die Slot Kulissen, auf die Lieblingsspielautomen von deutschen Spielern und mehr.

Unser professionelles Team sorgt dafür, dass Sie die neusten Trends nie verpassen.

Oder eine Übersicht über alle Spiele zu haben, die Sie noch nie gespielt haben?

Viele Casinomarken arbeiten außerdem mit uns zusammen, um exklusive Bonusaktionen anzubieten, die Sie sonst nirgendwo finden.

References:

https://online-spielhallen.de/wazamba-casino-promo-code-ihr-weg-zu-spannenden-belohnungen/

Außerdem können Sie Gruppenangebote für private Pokerabende einholen und sich an der Bar mit

Getränken und Snacks versorgen. Nur dort hat man die

Möglichkeit, Spielautomaten und diverse Tischspiele mit echten Dealern zu kombinieren. Dann begutachten Sie die

speziell eingerichtete Kategorie für die Spiele, die auch in der echten Spielothek angeboten werden. Dort erwarten Sie noch jede Menge weiterer

Slots von zahlreichen anderen Anbietern, auch wenn Sie hier ebenfalls auf Live- und Casino Tischspiele verzichten müssen. Auch ohne Live Tischspiele werden Sie im Löwenplay Casino dennoch Spaß mit den über 60 Spielautomaten haben.

Die Spielbank Bremen ist ein Unternehmen der Westspiel-Gruppe.

Die Spielbank Bremen befindet sich im historischen Kontorhaus an der Bremer Vergnügungsmeile

Schlachte, welches direkt im Zentrum an der Weser liegt.

Sie wird jedoch nahe zur Innenstadt betrieben, dort gibt es eine breite

Auswahl von Hotels unterschiedlicher Kategorien. Die Spielbank Bremen liegt direkt an der

Vergnügungsmeile Schlachte, nicht weit von der Weser entfernt.

Da sich die Spielbank Bremen in der Innenstadt befindet, ist die Anfahrt

mit dem Auto problemlos möglich.

Das Landesglücksspielgesetz sieht eine Einschränkung des Glücksspiels im Bundesland vor, um Spieler zu schützen. Spieler in Bremen können aus mehr Casino Seiten als regulären Spielbanken wählen und haben entsprechend Zugriff auf ein weitaus größeres Spielangebot im Internet.

Wir nehmen nur Internet Glücksspiel Anbieter in unsere Empfehlungen auf, wenn diese

durch eine entsprechende Konzession auch wirklich geeignet sind.

Die 16 Bundesländer haben Landesglücksspielgesetze auf Grundlage

eines Glücksspielstaatsvertrags verabschiedet. In der Europäischen Union gestaltet jedes Land eigene Glücksspielgesetze, es gilt aber gleichzeitig auch EU Recht.

Wir erklären Ihnen die Unterschiede zwischen dem

landbasierten Spiel und Casino Seiten online.

References:

https://online-spielhallen.de/joo-casino-freispiele-ihr-schlussel-zu-kostenlosem-spielspas/

The question of online casino legality in Australia is

challenging to answer. They have closely inspected each and

every online casino to handpick the ones worth your while.

Without further ado, let’s begin this adventure with a list that can help you find

an online casino that will be a perfect fit for you.

If you ever come across a problem that you can’t solve

with an online casino from our list, we’re here to help.

Signing up with any of my recommended real money Australian online casinos gives you access to over 5,000 games, sometimes even double that.

Jeetcity, like many online casinos, dangles the carrot

of enticing casino bonuses to attract new players and keep existing ones engaged.

It offers over 6,000 real money games, trusted payment options, along with a A$11,000 welcome bonus and a ton of promotions for loyal players.

Australian online casinos offer welcome bonuses, deposit bonus, free spins, loyalty

rewards, and some sort of cashback on losses. The newest online casinos for Australian players

aren’t just pokies platforms anymore — they’re full-scale gaming libraries

designed for every kind of player. Every online casino Australia real money players

prefer that made it on our list is fully optimised for mobile play — whether through a dedicated

app or responsive browser gameplay.

References:

https://blackcoin.co/bet365-casino-review-november-2025/

50+ providers including Pragmatic Play, NetEnt, Evolution Gaming, BGaming, Yggdrasil,

Playtech, Betsoft, Nucleus Gaming King Billy Casino has firmly established

itself as a prestigious online gaming destination since its opening in 2017.

Dive headfirst into the exhilarating journey that awaits,

assured that King Billy has smoothed your path, illuminated your landscape,

and prepared your gaming throne with utmost care.

Our mission is to offer a seamless, welcoming

entry into your tailored King Billy Casino experience.

With advanced encryption and vigilant session monitoring, your focus remains fiercely

fixed on each moment of joy. Available 24/7 through live chat and email, our

seasoned experts are poised to deliver prompt, professional solutions to

any login-related queries.

Players should create strong passwords and activate two-factor authentication (2FA) for extra security.

Security is key when logging into an online casino, King Billy

makes sure every casino login Australia is protected by state of the art encryption. The

most common issues are wrong passwords, blocked accounts, browser compatibility problems and location based

restrictions.

Click it, create a new password following the requirements (at least 8 characters with

a mix of letters and numbers), and you’re back in business.

Click the “Forgot Password” link on the login page and enter your registered email address.

When you genuinely can’t remember your password, King Billy Casino makes recovery simple.

Then verify your password – watch out for caps lock and make sure you’re not accidentally adding extra

spaces. Many people have multiple email accounts and mix them up.

If you see an “Invalid login” message, double-check your email address first.

References:

https://blackcoin.co/the-star-casino-a-comprehensive-guide/

There are no craps tables in Florida as of 2021, though the state’s new Florida-Seminole

compact allows for live craps at Seminole casinos going forward.

There are no provisions in state law to allow the Seminole to host online gambling games, online sports betting,

or online poker. There are six Class III tribal casinos and one Class II tribal casino.

For most North Florida residents, of course, online gambling is the only

real option for convenient play. However, if you’re

in the northern part of the state, there’s really nothing in Georgia to speak of, and Alabama has no legal casinos at all.

If you’re looking for casinos close to Tampa, casinos in Orlando,

or Casinos in Miami or south Florida, there are plenty

of options.

Odos is a rising crypto DEX aggregator that’s

gaining popularity for its ultra-transparent interface and smart trade execution. Ox Aggregator rises among the best DEX aggregators in 2025, recognized for helping traders get the best price deal.

If you are a liquidity provider or trader, KyberSwap is designed for you to offer tools to efficiently trade

and earn rewards.

Providers defining getting price, quote, limit orders,

ets interfaces for specificProvider(DEX aggregator).

To add new provider you need to create a new module in providers_clients folder module,create a class that

inherits from BaseProvider and implement abstract methods.

If provider doesn’t support one of order types, then this spender address for this ordertype should be null.

Provider’s config is a JSON with provider’s name, display name and supported chains.Every chain is an object with spender address for market order and limit order.

No contribution is to small no matterwhat it is, it could be adding of support for another provider,

bug fixes, new featuresor whatever. Clients are used to communicate

with external providers.

References:

https://blackcoin.co/crown-perth-in-depth-guide/

Discover how TeamViewer AI helps your support team resolve issues faster

and work more efficiently. Open the TeamViewer web or desktop client on the outgoing device and create a

remote session. Stay on top of personal device updates and maintenance no matter where you are.

Lightweight application, with no services running

all the time. It is the most widely adopted security

ratings solution for all industries and markets. Get insights across performance, applications, operating systems, security,

and networking categories.

Define permissions and ensure only authorized users can establish remote connections, enhancing security

for businesses of all sizes. Yes, Microsoft Remote Desktop Protocol (RDP) is a free

remote access tool, but it requires complex network setups

and lacks TeamViewer’s ease of use and security.

TeamViewer remains committed to maintaining this PC

to PC remote access free of charge while providing premium

options for businesses and power users who require

additional features. Simply launch the software, enter your partner ID on a

device you want to access, and get instant access to your remote device.

Boost productivity with AI-powered insights and automation, from real-time session summaries to

in-session troubleshooting with Tia. Every session is safeguarded with AES-256 bit encryption and TLS 1.2

protocols, providing the highest level of security.

Experience seamless cross-platform connectivity, enterprise-grade end-to-end encryption, and AI-enhanced performance.

If you are already an existing customer, please

visit the Customer Portal for licensing options.

Please be aware that this trial is only intended for prospective customers interested

in buying TeamViewer.

References:

https://blackcoin.co/king-billy-casino-login/

online blackjack paypal

References:

https://www.flughafen-jobs.com/companies/best-online-casinos-that-accept-paypal-in-2025/

paypal online casinos

References:

workmall.uz

paypal casino usa

References:

https://www.azena.co.nz/

online casino usa paypal

References:

https://recruitment.econet.co.zw/employer/us-online-casinos-that-accept-paypal-2025/

online casino with paypal

References:

https://jobs.foodtechconnect.com/companies/best-real-money-online-casinos-top-10-in-december-2025/

mobile casino paypal

References:

https://glimpsonworld.com/employer/477/in-depth-reviews-bonuses

casino sites that accept paypal

References:

https://remotejobs.website/profile/marygaby734131

paypal casinos online that accept

References:

https://supplychainjobs.in/employer/best-real-money-online-casino-sites-worldwide/

online casino for us players paypal

References:

https://ehrsgroup.com/employer/paypal-roulette-play-online-roulette-with-paypal-for-real-money/

casino avec paypal

References:

https://itheadhunter.vn/jobs/companies/best-new-online-casinos-in-2025/

Ich habe schon andere Casinos ausprobiert, aber Ice Casino online ist mein Favorit! Es bietet ein besseres Gesamterlebnis als Betway Casino und 888 Casino. Die Lizenz erlaubt es Ice Casino online, legale Glücksspieldienste in zugelassenen Ländern anzubieten. Die folgende Tabelle enthält Details zu den verfügbaren Zahlungsmethoden bei Ice Casino online. Ice Casino 28 bietet mehrere Zahlungsoptionen für schnelle Einzahlungen und Abhebungen.

Eines der besten mobilen Casinos, Ice Casino, bietet eine bequeme und unterhaltsame Möglichkeit, Casino Spiele zu erleben und zu gewinnen. Darüber hinaus haben wir einen Überblick über die verschiedenen mobilen Casino Spiele und die Möglichkeit, um echtes Geld zu spielen. Wir haben herausgefunden, dass Ice Casino ein führendes Online-Casino ist, das Spielern ermöglicht, alle Casinospiele auf ihren Mobiltelefonen zu spielen. Außerdem können Sie Ihren Fortschritt und Ihre Gewinne verfolgen, egal ob Sie auf dem Mobilgerät oder dem Desktop spielen. Mit einem Konto haben Sie Zugriff auf Ihre Lieblings-Casinospiele, unabhängig davon, ob Sie von Ihrem Mobiltelefon oder Ihrem Computer aus spielen.

References:

https://s3.amazonaws.com/new-casino/verde%20casino%20promo%20code.html

References:

4 week anavar before and after male

References:

http://pattern-wiki.win/index.php?title=richterbarnes8042

References:

Anavar before and after latest

References:

https://rentry.co/fbv6nid2

References:

Anavar winstrol before and after

References:

https://chessdatabase.science/wiki/Candy96_Australia_Pokies_Bonuses_Fast_PayID_Payouts

References:

Club gold casino

References:

https://telegra.ph/Winz-io-Casino-Review-Zero-Wagering-Bonuses-2026-01-07

References:

Slots of vegas no deposit codes

References:

https://bookmarkfeeds.stream/story.php?title=aussie-dollar-casino-payments

References:

Tuscany suites and casino

References:

http://ezproxy.cityu.edu.hk/login?url=https://wd40casino.blackcoin.co

References:

World casino

References:

https://theflatearth.win/wiki/Post:Get_225_up_to_AU7500_250_Free_Spins

beginner steroid cycle for sale

References:

https://securityholes.science/wiki/Buy_Steroids_Online_in_USA

effects of medical steroids

References:

http://muhaylovakoliba.1gb.ua/user/rulefont81/

References:

Test tren anavar before and after

References:

https://cameradb.review/wiki/4_Week_Anavar_Before_and_After_Transformations_Results_and_Considerations

References:

Anavar before and after results

References:

https://500px.com/p/emersonqnhjohns

bodybuilding supplements steroids

References:

http://theconsultingagency.com/members/lizardyam1/activity/4364/

%random_anchor_text%

References:

https://wifidb.science/wiki/Testosterone_Boosters_How_to_Boost_Testosterone_Naturally_Over_50

muscle mass pills gnc

References:

http://stroyrem-master.ru/user/sailsink49/

References:

Learn to play craps

References:

https://king-bookmark.stream/story.php?title=jeux-gratuits-en-ligne-jouez-maintenant-

References:

Double diamond slots

References:

https://hack.allmende.io/s/NmC4lBHv5Y

References:

Souper spectacle montreal

References:

https://www.repecho.com/author/playskill6/

References:

Best penny slot machines to play

References:

https://securityholes.science/wiki/Online_Casino_De_Beste_Online_Casinos_van_Nederland_voor_2025

steroids meaning

References:

https://coolpot.stream/story.php?title=achtung-testosteron-tabletten-im-test-10-produkte-im-vergleich

%random_anchor_text%

References:

https://bookmarks4.men/story.php?title=tout-savoir-sur-le-clenbuterol-usage-dosages-et-achat-en-ligne

%random_anchor_text%

References:

https://md.inno3.fr/s/C4Ywafm0p

crazy mass bulking stack

References:

https://browning-eliasen.federatedjournals.com/ou-acheter-du-trenbolone-parabolan

References:

Jackpot poker

References:

https://telegra.ph/Holen-Sie-sich-Ihren-Bonus-01-26

References:

No deposit bonus poker

References:

https://xypid.win/story.php?title=enjoy96-casino-australia-2025-play-now-2

References:

Tucson casino

References:

https://sciencewiki.science/wiki/96_com_1_Trusted_Online_Casino_Sports_and_Crypto_Betting_Site

References:

Windcreek casino atmore al

References:

https://able2know.org/user/bucketspleen5/

super trenabol stack

References:

https://instapages.stream/story.php?title=come-assumere-dianabol-comprendere-rischi-e-benefici

fast muscle growth pills

References:

https://gaiaathome.eu/gaiaathome/show_user.php?userid=1827442

steroid pill names

References:

https://ekademya.com/members/piedesert74/activity/177531/

sustanon for cutting

References:

https://cuwip.ucsd.edu/members/pintjune54/activity/2767018/

Wonderful blog! I found it while searching on Yahoo News. Do you have any suggestions on how to get listed in Yahoo News? I’ve been trying for a while but I never seem to get there! Many thanks

References:

Playboy casino cancun

References:

https://opensourcebridge.science/wiki/Angebotscodes_Casinos_Wettanbieter_2026_DE_CH_AT

References:

Rules of blackjack

References:

https://md.ctdo.de/s/7IqjkAYzJx

References:

Casino fandango

References:

https://clashofcryptos.trade/wiki/Erfahrungen_2025_Bonus_200

References:

Best penny slot machines to play

References:

https://historydb.date/wiki/888_Casino_Promo_Codes_2026_No_Deposit_Bonus_Free_Spins

References:

Best online casino sites

References:

https://maps.google.no/url?q=https://online-spielhallen.de/400-casino-bonus-2025-beste-angebote-fur-deutschland/

References:

Latest casino bonus

References:

https://adsintro.com/index.php?page=user&action=pub_profile&id=776946

References:

Catalina island casino

References:

https://peatix.com/user/28832389

References:

Elencasino

References:

https://aryba.kg/user/layerpush58/

crazy mass bulking stack

References:

https://rentry.co/vo5buxsm

buy peds online

References:

https://500px.com/p/fromkhzarcher

anabolic steroids unleashed

References:

http://mozillabd.science/index.php?title=putnamseerup6105

strongest bodybuilding supplements

References:

https://king-bookmark.stream/story.php?title=wirkstoff-zur-gewichtszunahme-anavar-wie-und-in-welcher-dosierung-fuer-den-sport-zu-nehmen-kaufen-online-zum

illegal steroid pills

References:

https://bom.so/FD7v6s

muscle roids

References:

https://graph.org/Anavar-10mg-50-tabs-Buy-Online-USA-02-05

best gnc pre workout 2016

References:

https://dating-scam.de/index.php?topic=1977.0

ip casino

References:

https://pad.geolab.space/s/Vzrj-yT0U

online casino sites

References:

https://squareblogs.net/studyquartz3/sicher-and-schnell

casino poker games

References:

http://fprints.com.ua/user/clefcoffee2/

pioneer casino laughlin

References:

https://mensvault.men/story.php?title=free-100-pokies-no-deposit-sign-up-bonus-reviews-read-customer-service-reviews-of-free100pokiesnodeposit-com

dover downs casino

References:

https://diego-maradona.org/user/mosquegram2/

ultimate texas hold em online

References:

https://telegra.ph/Treue–und-VIP-Programme-Online-Casino-Bonus-Guide-02-23

casino new brunswick

References:

https://invastu.kz/user/foodwomen8/

seminole casino immokalee

References:

https://drew-caspersen-3.federatedjournals.com/fair-go-casino-pokies-complete-guide-to-online-pokies-in-australia

vegas skyline

References:

https://lit-book.ru/user/modemliquid7/

%random_anchor_text%

References:

https://firsturl.de/c5N2AwR

%random_anchor_text%

References:

http://tehnoprom-nsk.ru/user/shellwool8/

%random_anchor_text%

References:

https://matkafasi.com/user/effectbrandy8

%random_anchor_text%

References:

https://able2know.org/user/saucebrandy8/

elliot hulse steroids

References:

https://trade-britanica.trade/wiki/Oxandrolon_Strafe_bei_Bestellung_Besitz_AntiDopG

casino action

References:

https://animallovergifts.com/dogtoys/

san francisco casinos

References:

https://vivek-desai.com/shortcodes/image-teasers/

best casino online

References:

https://www.westley.com.au/events/world-famous-places-exhibition/

minnesota casinos

References:

http://schlatthof.net/togo-reise-november-2023/es-geht-gleich-in-die-vollen-uns-erster-tag-in-togo/

pure 6 extreme formula anabolic

References:

https://sportpoisktv.ru/author/waycarp5/

why do bodybuilders die young

References:

https://hack.allmende.io/s/zMZFj-tlb

discount prescriptions

cheap meds no prescription